14.4.1 LeNet -5

가장 널리 알려진 CNN 구조

in 1998 made by 얀 르쿤 MNIST인식에 사용

28 x 28 이지만 제로 패딩되어 32 x 32되고 네트워크 주입 전 정규화

나머지는 패딩 x

average fooling layer : 평균 계산 -> 학습되는 계숫값 곱 -> 편향값 더하기 -> 활성화함수 적용

C3 : S2의 3개 또는 4개 맵에 있는 뉴런에만 연결

출력층 : 뉴런에서 입력 벡터와 가중치 벡터 사이의 유클리드 거리 출력, 출력은 이미지가 얼마나 특정 숫자 클래스에 속하는지 측정 (최근에는 예측 줄이고 gradient값 크고 빠르게 수렵되는 cross entropy cost function 선호)

14.4.2 AlexNet

in 2012 이미지넷 대회에서 큰 차이로 우승 17%!

made by 알렉스 크리체프스키, 일리아 서스케버, 제프리 힌턴

더 크고 깊은 LeNet-5으로 비슷함

합성곱 층 위에 풀링층 x -> 바로 합성곱 층끼리 쌓음

과대적합 줄이기 위한 2가지 규제 기법

1. dropout 0.5비율 적용

2. data augmenation

train image 랜덤하게 여러 간격으로 이동, 수평으로 뒤집고, 조명을 바꿈

C1, C3 층의 ReLU 단계 이후 LRN(local response normalization)

: 가장 강하게 활성화된 뉴런이 다른 특성 맵에 있는 같은 위치의 뉴런 억제

-> 특성 맵을 각기 ㅌ특별하게 다른 것과 구분, 더 넓은 시각에서 특징 탐색

=> 일반화 성능 향상

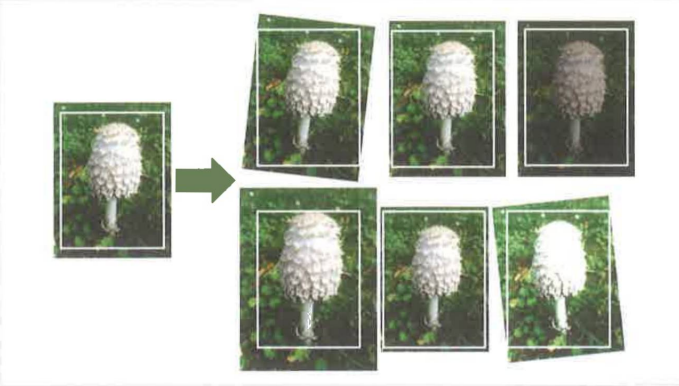

data augmenation

진짜 같은 훈련 샘플을 인공적으로 생성해 훈련 세트의 크기 늘림

생성된 샘플은 가능한 진짜에 가까워야 함

증식된 것인지 아닌지 구분할 수 없어야 함

white noise 추가하는 것은 도움 안 됨

ex) 이미지 크기 변경, 이동, 회전 -> 물체의 위치, 방향, 크기 변화에 덜 민감

'Machine Learning & Deep Learning > 핸즈온' 카테고리의 다른 글

| ch17. 오토인코더와 GAN ~ 17.1 효율적인 데이터 표현 (0) | 2023.11.28 |

|---|---|

| 핸즈온 ch.4 모델 훈련(선형회귀, 경사 하강법) - 미완 (0) | 2023.08.29 |

| 핸즈온 ch15. RNN과 CNN을 사용해 시퀀스 처리하기 (0) | 2023.08.29 |

| 핸즈온 퍼셉트론 Perceptron - 공부 아직 다 안함 ㅋㅋ (0) | 2023.08.29 |

| 핸즈온 신경망 하이퍼파라미터 튜닝하기 (0) | 2023.07.13 |